Robots.txt : les informations essentielles

Qu’est-ce que le fichier robots.txt et à quoi sert-il ?

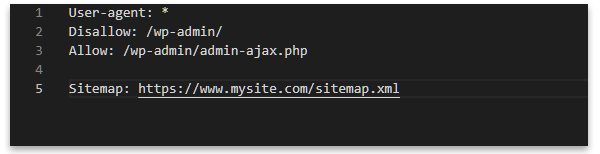

Robots.txt est un simple fichier texte à la racine de votre site (voir ci-dessous) qui donne aux moteurs de recherche des instructions sur les zones d’un site ou les fichiers qu’ils doivent ou ne doivent pas explorer (voir image ci-dessous). Il n’empêchera pas les urls d’être explorées ; pour cela, il est préférable d’utiliser une protection par mot de passe.

Une fonction importante de robots.txt est d’informer les moteurs de recherche de l’emplacement de vos sitemaps, comme dans l’exemple ci-dessous :

Un fichier robots.txt est-il nécessaire ?

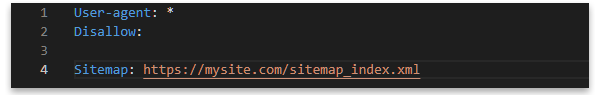

Oui ! Non seulement il donne des informations sur les parties du site qui ne doivent pas être explorées et sur l’emplacement des sitemaps, mais il est aussi un indicateur d’un site bien fait. Google, Bing et les autres moteurs de recherche rechercheront ce fichier sur votre site et s’ils ne le trouvent pas, votre site sera considéré comme étant de moindre qualité. Il doit donc être présent, même s’il ne contient que les informations par défaut, comme ceci :

NOTE: J’ai vu des exemples où il n’y a pas de retour à la ligne après « User-agent: *« , et dans ce cas, les robots ignorent simplement la directive qui la suit.

Où doit-on placer le fichier robots.txt ?

Il doit être à la racine de votre site (au même niveau que index.php ou index.html) et accessible avec l’url « https://www.mydomain.com/robots.txt », en remplaçant le nom de domaine par le vôtre comme dans l’exemple ci-dessous pour mon site :

En savoir plus

Le site des développeurs de Google contient de nombreuses informations utiles :

Introduction au robots.txt sur developers.google.com (vous pouvez le mettre en français)

Instructions de Google sur comment créer le fichier